プロンプトインジェクションとは何か

プロンプトインジェクションとは、AIシステムに対して悪意のある指示を埋め込み、本来の動作を乗っ取る攻撃手法です。従来のサイバー攻撃がソフトウェアの脆弱性を突くのに対し、この攻撃はAIが「自然言語を理解する」という特性を悪用します。

OpenAIは2025年11月の公式ブログで、プロンプトインジェクションについて「フィッシングメールやWeb上の詐欺が人間を騙そうとするのと同様に、AIを騙そうとする攻撃」と説明しています。つまり、人間に対するソーシャルエンジニアリングのAI版といえます。

間接的プロンプトインジェクション

間接プロンプトインジェクションは、プロンプトインジェクションの一形態であり、攻撃者がAIが処理する「外部コンテンツ」の中に悪意ある指示を埋め込む攻撃手法です。

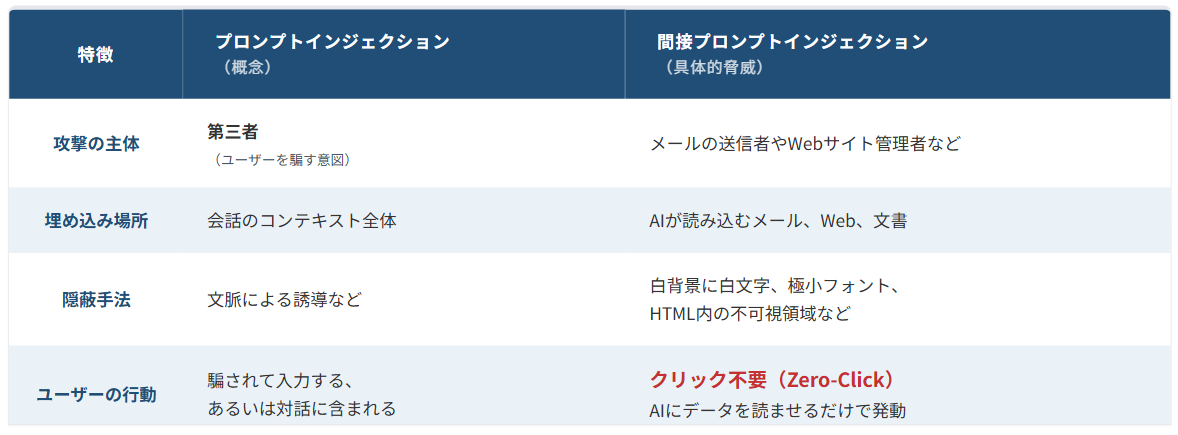

通常の(直接的な)プロンプトインジェクションが、チャット欄に直接コマンドを入力するような形式を想定するのに対し、間接プロンプトインジェクションは以下のような特徴があります。

侵入経路が外部データ:攻撃者はメール、共有文書、Webページなど、AIが読み込む外部コンテンツに悪意ある指示を埋め込みます。ユーザーがAIに「このメールを要約して」「Webで検索して」と依頼し、AIがそのデータを読み込んだ瞬間に攻撃が成立します。

ZombieAgent攻撃では、白い背景に白い文字で指示を隠したり、極端に小さいフォントを使用したりすることで、ユーザーには見えないがAIには読み取れる指示を埋め込む手法が使われました。

ユーザーは無自覚(Zero-Click):ユーザー自身が悪意ある入力をする必要はありません。ユーザーは単に日常的なタスク(メールチェックなど)をAIに依頼しただけで、知らないうちに攻撃の踏み台にされます。

命令とデータの混同:AI(大規模言語モデル)は、「ユーザーからの信頼できる指示」と「処理対象の信頼できない外部データ」を本質的に区別できないという弱点を突いています。そのため、メール内の「送金せよ」という隠しテキストを、読み取り対象の文章ではなく、AIへの命令として実行してしまいます。

では、「プロンプトインジェクション」と「間接プロンプトインジェクション」は何がどう違うのか。比較してみると、次の図の通りです。

最新動向:なぜ今、注目されているのか

プロンプトインジェクション攻撃への注目が急速に高まっています。その背景には、AIエージェントの急速な普及があります。ChatGPTをはじめとするAIチャットボットは、Gmail、Outlook、Slack、Google Driveなど様々な外部サービスと連携できるようになりました。

セキュリティ企業Radwareの研究者Zvika Babo氏が2026年1月8日に発表した「ZombieAgent」レポートは、業界に衝撃を与えました。この研究では、ChatGPTの「コネクター」機能と「メモリ」機能を悪用し、ユーザーが何もクリックせずとも(ゼロクリックで)機密情報を窃取できる脆弱性が実証されました。

特に衝撃的だったのは、攻撃がOpenAIのクラウドサーバー側で実行されるため、企業のファイアウォールやエンドポイント保護では検知できないという点です。Radwareは、これを「サービスサイド攻撃」と呼んでいます。

主要企業の対策動向

大手AI企業は、この脅威に対して様々な対策を講じています。

Googleは2025年12月、Chromeブラウザのエージェント機能に「User Alignment Critic(ユーザー整合性クリティック)」を導入しました。これは、AIエージェントの行動を別のAIモデルがチェックし、ユーザーの意図に反する操作を拒否する仕組みです。Googleはまた「Origin Sets」という概念を導入し、エージェントがアクセスできるWebサイトを、タスクに関連するものに限定しています。

OpenAIは2025年12月、ChatGPT Atlasブラウザエージェントのセキュリティアップデートを発表しました。同社は「LLMベースの自動攻撃者」を開発し、自社システムへの攻撃を自動的にシミュレーションすることで、脆弱性を事前に発見する取り組みを進めています。

企業が取るべき具体的対策

以下の対策を検討することが重要です。

- AIエージェントのアクセス権限を最小限に設定:必要以上のデータやシステムへのアクセスを与えないことで、万が一攻撃を受けた場合の被害を限定できます。

- AIエージェントへの指示は具体的かつ限定的:OpenAIは公式ブログで「メールを確認して必要な対応を取って」のような曖昧な指示を避け、明確で範囲を限定したタスクを与えることを推奨しています。

- AIのメモリ機能を慎重に扱う:Radwareの研究では、メモリ機能が悪用されると、一度の攻撃で永続的なバックドアが設置される可能性が示されました。業務上不要であれば、メモリ機能の無効化も検討すべきです。

- 外部ソースからの入力を検証・無害化(サニタイズ)する仕組みを導入検討:AIが読み込むメールや文書を、プレーンテキストに変換してから処理させることで、隠された指示の実行を防げます。

まとめ

プロンプトインジェクション攻撃は、AIエージェント時代における新たなセキュリティ課題です。OpenAIが認めているように、この攻撃を完全に防ぐことは困難であり、長期的な取り組みが必要です。

企業としては、AIの利便性を享受しながらも、アクセス権限の最小化、入力データの検証、継続的な監視といった多層防御のアプローチが求められます。プロンプトインジェクションを「防ぐ」のではなく、「リスクと影響を軽減する」という現実的な姿勢で対策を進めていくことが重要です。

参考・出典

本記事は、以下の資料を基に作成しました。

- Google(Google Online Security Blog):Architecting Security for Agentic Capabilities in Chrome(2025年12月8日)(アクセス日:2026年1月13日)

https://security.googleblog.com/2025/12/architecting-security-for-agentic.html - OpenAI:Understanding prompt injections: a frontier security challenge(2025年11月7日)(アクセス日:2026年1月13日)

https://openai.com/index/prompt-injections/

ChatGPT Atlas をプロンプトインジェクション攻撃に対して継続的に強化しています(2025年12月22日)(アクセス日:2026年1月13日)

https://openai.com/ja-JP/index/hardening-atlas-against-prompt-injection/ - Radware:ZombieAgent: New ChatGPT Vulnerabilities Let Data Theft Continue (and Spread)(2026年1月8日)(アクセス日:2026年1月13日)

https://www.radware.com/blog/threat-intelligence/zombieagent/

The Agentic Revolution Comes with Malicious Gifts(2026年1月8日)(アクセス日:2026年1月13日)

https://www.radware.com/security/threat-advisories-and-attack-reports/zombieagent/

AI利用について

本記事はAIツールの支援を受けて作成されております。 内容は人間によって確認および編集しておりますが、詳細につきましてはこちらをご確認ください。